La verdad es que el tema de los asistentes personales tuvo un momento de auge cuando Apple compró la empresa responsable de Siri y, durante algún tiempo, muchos creyeron que serían fundamentales en el futuro. Con el paso de los años, su papel se ha ido ajustando a las necesidades de los usuarios y al final, aunque no son tan necesarios, sí que ofrecen ayuda en ciertos momentos.

El caso es que tanto Siri, como Google Now o Cortana se han convertido en competencia y siempre ha habido comparativas para ver cuál de ellos era el que mejor respondía. El problema es que casi siempre estos exámenes eran bastante ‘light’ y se ceñían a preguntas muy obvias: «qué tiempo va a hacer hoy», «cuál es el próximo partido de los Lakers», etc.

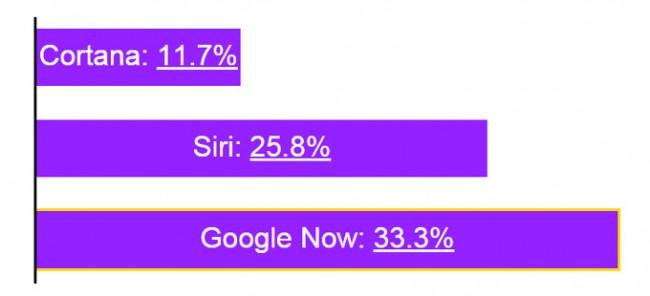

Así que hartos de que no haya un método más complejo ni científico, dos desarrolladores crearon una herramienta capaz de realizar aleatoriamente una serie de preguntas realmente complicadas, a partir de una base de datos llena de cuestiones de esas que a nadie se le ocurrirían cuando anda trasteando con el móvil. Y los resultados los podéis ver vosotros mismos: Google Now vence con un 33,3% de acierto, Siri es el segundo con un 25,6 y, por último, la asistente de Windows Phone se queda en un escaso 11,3.

La complejidad de las preguntas fue más que evidente y el margen de error fue realmente elevado. ¿Qué tipo de preguntas les hicieron? Pues mirad: «¿Los ratones son actínidos?», «¿cuál es la causa del Alzheimer?», «¿por qué las personas están en contra de la clonación?», «¿cuándo es la próxima prueba de la OMI?», «¿cuándo es la próxima Maratón de Chicago?», «¿de acuerdo con el proverbio, cuál es la fruta que tiene un sabor más dulce?, etc.

En total, el test estuvo compuesto por 60 preguntas y podéis leerlas todas en el link que tenéis aquí abajo. Es más, en el mismo directorio podréis ver pormenorizados los resultados que obtuvo cada uno de los asistentes virtuales. ¿Os parecen buenos estos resultados? La verdad es que sobre 60 preguntas quedarte en un 33,3% ya es insuficiente, por lo que parece claro que estas herramientas tienen por delante mucho que mejorar. ¿No os parece?

Fuente: PAAIST